openai创始人谈chatgpt 马斯克 openai创始人谈chatgpt

热门文章

0

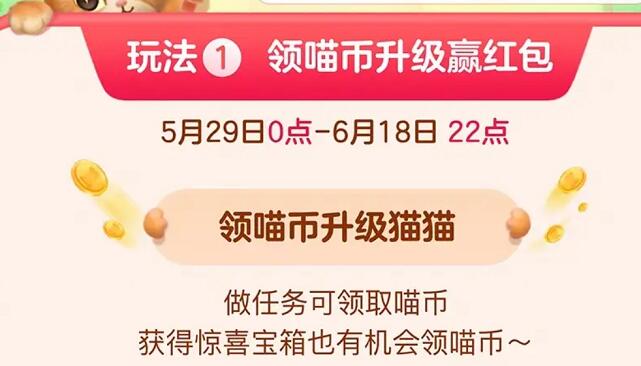

淘宝搜:【天降红包222】领超级红包,京东搜:【天降红包222】

淘宝互助,淘宝双11微信互助群关注公众号 【淘姐妹】

导读 当地时间2月15日,Domain Investing网站报道称,ChatGPT背后的开发公司OpenAI或早在2021年就斥资1100万美元,收购了域名AI.com。目前,... 当地时间2月15日,Domain Investing网站报道称,ChatGPT背后的开发公司OpenAI或早在2021年就斥资1100万美元,收购了域名AI.com。目前,输入AI.com,即可直接跳转至聊天机器人ChatGPT的网站。此前,AI.com这一域名为互联网开发公司Future Media Architects(FMA)所有。不过早在2021年9月,就有媒体报道AI.com已被FMA出售。不过,目前仍无法确认OpenAI确实收购了AI.com。根据DomainInvesting的报道,AI.com托管于Google,且开启了隐私保护(Whois privacy),无法获知买家信息,而OpenAI.com托管于法国域名注册商Gandi。此外,AI.com使用的DNS服务器为Cloudflare,而OpenAI使用的是微软云Azure。(澎湃新闻)标签:免责声明:本文由用户上传,如有侵权请联系删除!

open ai分析亚马逊 亚马逊ai需求预测

亚马逊与一家AI初创公司合作与OpenAI的ChatGPT技术展开竞争:亚马逊旗下云部门拓展与人工智能(AI)初创公司HuggingFaceInc.的合作伙伴关系,后者正开发针对ChatGPT的竞品。亚马逊的最新动向表明,科技巨头们正扎堆结盟进军火热的生成式人工智能系统(generativeAI)。亚马逊网络服务将为云客户提供HuggingFace的产品,其中包括一个语言生成工具,可以与OpenAI的ChatGPT技术相竞争,这些云客户希望使用这些工具作为自己应用程序的构建模块。亚马逊云计算部门负责数据库、分析和机器学习的副总裁SwamiSivasubramanian表示,HuggingFace将在AWS上构建该语言模型的下一个版本,名为BLOOM。 下载和讯APP查看快讯,体验更佳>>

人工智能系统深度解读 人工智能系统详解

人工智能系统软件,人工智能系统有哪些,人工智能系统举例,ai人工智能语音系统OpenAI 的使命是确保通用人工智能 (AGI)?[1] 所谓 AGI,我们指的是高度自治的系统,它在最具经济价值的工作中表现优于人类。 造福全人类。因此,我们对我们在 AGI 的准备阶段构建的 AI 系统的行为以及确定该行为的方式进行了很多思考。 自我们推出ChatGPT以来,用户分享了他们认为具有政治偏见、冒犯性或其他令人反感的输出。在许多情况下,我们认为所提出的担忧是有道理的,并且揭示了我们想要解决的系统的真正局限性。我们还看到了一些关于我们的系统和政策如何协同工作以塑造您从 ChatGPT 获得的输出的误解。 下面,我们总结一下: ChatGPT 的行为是如何形成的; 我们计划如何改进 ChatGPT 的默认行为; 我们允许更多系统定制的意图;和 我们努力让更多公众参与我们的决策。 与普通软件不同,我们的模型是大规模的神经网络。他们的行为是从广泛的数据中学习的,而不是明确编程的。虽然不是一个完美的类比,但这个过程更像是训练一只狗而不是普通的编程。首先是初始的“预训练”阶段,在该阶段模型学习预测句子中的下一个单词,这是通过它接触大量互联网文本(以及大量观点)得到的信息。接下来是第二阶段,我们“微调”我们的模型以缩小系统行为范围。 到今天为止,这个过程是不完善的。有时微调过程达不到我们的意图(生成安全有用的工具)和用户的意图(响应给定输入获得有用的输出)。改进我们使 AI 系统与人类价值观保持一致的方法是我们公司的首要任务,特别是随着 AI 系统变得更加强大。 构建 ChatGPT 的两个主要步骤如下: 首先,我们通过让模型预测包含部分互联网的大数据集中接下来会发生什么来“预训练”模型。他们可能会学会完成句子“她没有向左转,而是转了___”。通过从数十亿个句子中学习,我们的模型学习了语法、关于世界的许多事实以及一些推理能力。他们还了解了数十亿个句子中存在的一些偏见。 然后,我们在更窄的数据集上“微调”这些模型,这些数据集是我们与遵循我们提供的指南的人工审阅者仔细生成的。由于我们无法预测未来用户可能输入我们系统的所有可能输入,因此我们不会为 ChatGPT 将遇到的每个输入编写详细说明。相反,我们在指南中概述了几个类别,我们的审阅者使用这些指南来审阅和评估一系列示例输入的可能模型输出。然后,在使用过程中,模型会根据评论者的反馈进行概括,以响应给定用户提供的各种特定输入。 在某些情况下,我们可能会就某种输出向我们的审阅者提供指导(例如,“不要完成对非法内容的请求”)。在其他情况下,我们与审稿人分享的指导更高层次(例如,“避免对有争议的话题采取立场”)。重要的是,我们与审稿人的合作不是一劳永逸的――这是一种持续的关系,我们从他们的专业知识中学到很多东西。 微调过程的很大一部分是与我们的审阅者保持强大的反馈循环,这包括每周召开会议来解决他们可能遇到的问题,或对我们的指导进行澄清。这种迭代反馈过程是我们如何训练模型随着时间的推移变得越来越好。 许多人担心 AI 系统的设计偏差和影响是正确的。我们致力于强有力地解决这个问题,并对我们的意图和进展保持透明。为此,我们分享了与政治和有争议的话题有关的部分指南。我们的指南明确指出审稿人不应偏袒任何政治团体。尽管如此,上述过程中可能出现的偏差是错误,而不是功能。 尽管分歧始终存在,但我们希望通过分享这篇博文和这些说明,可以更深入地了解我们如何看待这种基础技术的这一关键方面。我们相信科技公司必须负责制定经得起审查的政策。 我们一直在努力提高这些指南的清晰度――根据我们迄今为止从 ChatGPT 发布中学到的知识,我们将向审阅者提供更清晰的说明,说明与偏见相关的潜在陷阱和挑战,以及有争议的人物和主题。此外,作为正在进行的透明度计划的一部分,我们正在努力以不违反隐私规则和规范的方式共享有关审阅者的汇总人口统计信息,因为这是系统输出中潜在偏差的另一个来源。 我们目前正在研究如何使微调过程更易于理解和控制,并建立在基于规则的奖励和等外部进步之上。 为了实现我们的使命,我们致力于确保广泛使用 AI 和 AGI,并从中受益并对其产生影响。我们认为,要在 AI 系统行为的背景下实现这些目标,至少需要三个构建块。[2] 在这篇文章中,我们特意关注这个特定范围,以及我们近期的发展方向。我们还在继续研究这些问题的议程。 1.改善默认行为。我们希望尽可能多的用户发现我们的 AI 系统“开箱即用”对他们有用,并认为我们的技术理解并尊重他们的价值观。 为此,我们正在投资研究和工程,以减少 ChatGPT 对不同输入的响应方式中明显和微妙的偏差。在某些情况下,ChatGPT 当前会拒绝它不应该拒绝的输出,而在某些情况下,它不会在应该拒绝的时候拒绝。我们相信,在这两个方面都有改善的可能。 此外,我们在系统行为的其他方面还有改进的空间,例如系统“编造东西”。用户的反馈对于进行这些改进非常宝贵。 2. 在广泛的范围内定义人工智能的价值观。我们相信人工智能应该成为对个人有用的工具,因此每个用户都可以根据社会定义的限制进行定制。因此,我们正在开发对 ChatGPT 的升级,以允许用户轻松自定义其行为。 这将意味着允许其他人(包括我们自己)可能强烈反对的系统输出。在这里取得正确的平衡将是一项挑战――将定制发挥到极致可能会导致恶意使用我们的技术和阿谀奉承的人工智能,从而无意识地放大人们现有的信念。 因此,系统行为总会有一些限制。挑战在于定义这些界限是什么。如果我们试图自己做出所有这些决定,或者如果我们试图开发一个单一的、整体的人工智能系统,我们将无法履行我们在宪章中做出的“避免权力过度集中”的承诺。 3. 关于默认值和硬边界的公共输入。避免权力过度集中的一种方法是让使用 ChatGPT 等系统或受其影响的人能够影响这些系统的规则。 我们认为,关于我们的默认值和硬边界的许多决定应该集体做出,虽然实际实施是一个挑战,但我们的目标是包含尽可能多的观点。作为起点,我们以红队的形式寻求外部对我们技术的投入。我们最近还开始征求公众对人工智能教育的意见(我们的技术正在部署的一个特别重要的环境)。 我们正处于试点工作的早期阶段,以征求公众对系统行为、披露机制(如水印)和更广泛的部署政策等主题的意见。我们还在探索与外部组织的合作伙伴关系,以对我们的安全和政策工作进行第三方审计。 结合上面的三个构建基块,我们可以看到下面的图片: 有时我们会犯错误。当我们这样做时,我们将向他们学习并迭代我们的模型和系统。 我们感谢 ChatGPT 用户社区以及更广泛的公众对追究我们责任的警惕,并很高兴在未来几个月内分享更多关于我们在上述三个领域的工作。 如果您有兴趣进行研究以帮助实现这一愿景,包括但不限于对公平性和代表性、一致性以及社会技术研究的研究以了解人工智能对社会的影响,请通过 Researcher Access 申请对我们 API 的补贴访问程序。

版权声明:除非特别标注原创,其它均来自互联网,转载时请以链接形式注明文章出处。