chatgpt 鏈夎叮鐢ㄦ硶 ChatGPT 璁粌鏁欑▼

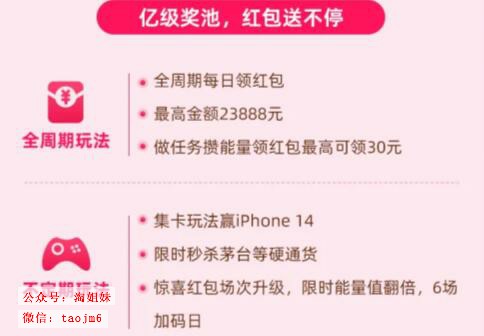

淘宝搜:【天降红包222】领超级红包,京东搜:【天降红包222】

淘宝互助,淘宝双11微信互助群关注公众号 【淘姐妹】

我不知道

//一直希望自己能写几个童话故事,讲给孩子听,非常高兴在ChatGPT帮助下实现了这个愿望。

童话1:韩非和小鬼魂安娜

韩非是一个可爱的小男孩,他爱冒险。

有一天,他在家后院玩耍的时候,发现了一个神奇的小门。他很好奇,于是他决定去看看这个门的后面到底是什么。

当他打开了门的时候,他看到了一个奇妙的世界――小鬼魂的世界。

其中有一个叫做安娜的小鬼魂,她看到了韩非,非常高兴,她立刻就喜欢上了这个可爱的小男孩。

安娜决定要和韩非成为好朋友。

他们不同的只是外表,但本质上都是友好的孩子。

然而,小鬼魂安娜和韩非有很多习惯不同。安娜喜欢在夜里玩耍,而韩非则喜欢在白天玩耍。安娜喜欢吃鬼气,而韩非则喜欢吃水果。

这些差异使得小鬼魂安娜和韩非之间产生了很多误会。韩非觉得小鬼魂安娜很奇怪,而小鬼魂安娜则觉得韩非很烦人。

但是,小鬼魂安娜很坚强,她决定不放弃和韩非成为好朋友的机会。于是,她带着韩非参观她的家,希望他更加了解小鬼魂。

他们先来到了小鬼魂安娜的卧室。韩非看到安娜的床是浮在空中的,非常奇怪。

"为什么这床漂浮在空中?" 韩非问。

"因为我喜欢在空中睡觉啊!" 小鬼魂安娜笑着回答道。

然后,他们又来到了安娜的厨房。

安娜说:"这是我的冰箱,你想吃点什么?"

韩非很惊奇:"哇,这些食物看起来好奇怪啊!"

安娜说:"没错,我们小鬼魂吃的是鬼气。不过,也有一些食物是可以让人类吃的。这些苹果,西瓜,香蕉都是可以让你吃的。"

韩非说:"谢谢,那我就吃点苹果吧!"

韩非发现小鬼魂安娜的生活方式和他的生活方式完全不同。

接下来他们开始做游戏。

小鬼魂安娜很擅长躲猫猫,因为她是个小鬼魂,所以她可以通过身体变幻来隐藏起来。

有时候,她会变成一个小花瓶,躲在桌子底下。有时候,她会变成一把小小的扫帚,藏在屋子的角落里。

安娜躲猫猫技术很高超,韩非经常都找不到她。但是,每次小鬼魂安娜都会在韩非最没期望的时候突然出现,吓得韩非喊出声来。

韩非非常喜欢和小鬼魂安娜玩耍。他觉得,躲猫猫是一种很有趣的游戏。而且,和小鬼魂安娜一起玩耍,总是能带给他意想不到的惊喜。

安娜是一个小鬼魂,鬼魂可以飞,可以穿过物体。

安娜带着韩非一起跳过月亮,感觉好像没有重力。他们俩像两只小天使一样,在空中自由地飞翔。韩非从来没有这么快乐过。

就这样,韩非和小鬼魂安娜成为了好朋友。

他们一起玩耍,并且互相学习对方的习惯,更加了解对方。

尽管他们外表不同,但他们都是好孩子。

**********************************

童话2:韩非和小蚂蚁

韩非是一个可爱的小男孩,他爱冒险,并且乐意帮助别人。

有一天,韩非的父母和妹妹出门了,留下了他一个人在家。

韩非觉得他应该好好照顾家里的东西,他决定打扫一下房间。

他在打扫卧室的时候,在床单里发现了一个奇怪的小盒子。

盒子看起来很古老,上面画着奇怪的符号。韩非很好奇,他想知道盒子里面是什么。

他轻轻地把盒子放到床上,准备打开盒子的盖子。

这时候,他听到了一个声音从盒子里传来。

声音很小,但是十分清晰。

声音告诉韩非,如果他愿意帮助盒子里的小生物,小生物就会满足他一个大大的愿望。

韩非很高兴,他决定帮助小生物。

打开盒子后,韩非发现盒子里的小生物原来是一只可爱的小蚂蚁。

小蚂蚁告诉韩非,它的家被大脚虫摧毁了,它需要韩非帮助它来修建新的家。

韩非很乐意帮助小蚂蚁,他和小蚂蚁一起走到了后院。

后院里有一片茂密的小草丛,韩非觉得这是个好地方。

他开始动手工作,他找了一些小木棍和泥巴,然后用小木棍搭建了一个小小的房子框架,用泥巴将房子的四周粘牢,最后再用一些树叶和草做房子的屋顶。

房子建好之后,小蚂蚁非常开心,它感谢韩非帮忙修建了这么漂亮的房子。

韩非也很高兴,他觉得自己做的很好。他知道自己应该帮助别人,做一个好孩子。

小蚂蚁说:"韩非,谢谢你,现在我可以帮助你实现一个愿望,你想要什么?"

韩非开心地说:"哇,真的吗?我想要很多东西!我想要一个新的超级英雄玩具,哦不,我还是要一大堆巧克力糖果吧。”

小蚂蚁说:“巧克力糖果吗?好的,我这就实现你的愿望。”

就在这时,韩非犹豫了。愿望是很珍贵的,不能轻易浪费。

韩非发现他虽然想要很多东西,但是他真正最爱的还是爸爸妈妈和妹妹。

他想了很久,最后说:"小蚂蚁,我反悔了。我不要超级英雄玩具和巧克力糖果了,我要把愿望改成爸爸妈妈和妹妹永远健康快乐。"

小蚂蚁点头笑了笑:"你是一个好孩子,我一定会帮助你实现这个愿望的。"

就这样,韩非帮助了小蚂蚁,并且许下了一个愿望,他成为了一个更加善良和孝顺的孩子,他的家人也得到了幸福。

**********************************

童话3:韩非和怪老鼠

韩非是个可爱的小男孩,他住在一个美丽的村庄里。

有一天,他的村庄遭到了一群怪兽的袭击。

这些怪兽是一群巨大的老鼠,它们有着锋利的爪子和牙齿,不怕猫;它们跑得非常的快,大人们根本追不上。

老鼠们抢走了村庄的所有食物。

没有吃的,所有人都饿得不行。

韩非也很饿,他走遍整个村庄,想找到赶走老鼠的办法。

"老鼠把食物都抢走了,大家都在饿着,我们该怎么办?" 韩非问。

"放弃吧,孩子。这些老鼠太厉害了,连猫和狗都赶不走它们。" 一位村民虚弱地说道。

"不,我相信一定会有办法的,我们不能放弃。" 韩非说道。

"但是这些老鼠跑得这么快,我们大人都拦不住,你小小年纪,怎么能做到呢?" 另一位村民问。

"我也不知道该怎么做,但是一定有人知道,我相信自己。" 韩非坚定地说道。

大人们都饿得绝望了,躺在地上一动不动,都放弃了。

只有韩非还保持着坚强的信心,饿着肚子,却还在寻找赶走老鼠的办法。

最后,他忍住饥饿,走出了村庄,来到了小镇。

在小镇里,他遇见了一位老巫师。

老巫师看见了韩非,感受到了他的善良和坚强,决定帮助他。

老巫师告诉韩非,这些大老鼠的力量来自于一种名叫"黑暗之力"的魔法。

只有拥有足够的信念和善良的人,才能打败黑暗之力。

韩非不知道自己是否拥有这两种品质,但是为了守护村庄,他必须试一试。

于是,老巫师带着韩非,找到了老鼠的巢穴。

老巫师指着黑暗的洞穴说,“孩子,剩下的就只能靠你自己了。”

韩非点点头,坚定地向前走去。

巢穴里充满了黑暗之力的气息,韩非走进来,发出了响声。

大老鼠听到声音,红着眼睛朝着韩非冲了过来,要咬他。

看到这么多大老鼠,韩非很害怕,但他知道自己必须要保持自信,才能成功。

于是,他深呼吸,聚拢了所有的善良和自信,没有后退,反而迎着老鼠向前冲去。

当他冲向老鼠时,他感觉到自己的力量越来越强,而面前的老鼠变得越来越小,最后大老鼠们变得只有花生米那么小。

韩非用他的拳头打着老鼠,一拳下去就打飞了好多老鼠。

就这样,所有的老鼠都被打败了,韩非靠着自信和善良,成功地打败了黑暗之力,拿回了被老鼠抢走的食物。

村庄里的人都为韩非的勇敢而感动,从此以后,韩非成为了村庄的英雄,大家都非常喜欢他。

**********************************

童话4:韩非的梦境之旅

韩非是个可爱的小男孩,他有一个四岁的妹妹,叫做小玲。

小玲非常喜欢和哥哥韩非一起玩。但是,韩非却觉得妹妹很烦人,常常表现得不耐烦。

因为他想自己出去和朋友玩,不想在家里陪妹妹。

有一次,小玲扯着韩非的衣服,要韩非陪自己玩耍时,韩非生气了。

他没有控制住自己的情绪,推开妹妹,对妹妹大吼道:“你烦死了,我要出门,你快让开!”

这可把妹妹吓坏了。

小玲坐在地上嚎嚎大哭,"哥哥不要出门,我想和你在家一起玩!"

可是韩非并没有意识到自己的错误,他没有向小玲道歉,而是推开门出去玩了。

被哥哥冷落的小玲在家里一直哭到晚上。

哥哥回来了,她还在伤心的哭着。

睡觉时间到了,在妹妹的哭声中,韩非睡着了。熟睡的韩非进入了一个奇妙的梦境。

在梦中,他来到了一个神秘的魔法森林,里面充满了各种各样的危险。

韩非有些害怕,他想离开这片森林,但是他发现他做不到。

因为森林里有好几个小动物在嚎嚎大哭,它们的眼泪汇聚在一起,变成了一条小河,拦住了韩非。

这可怎么办呀?难道我要被困在这里了吗?韩非看着这条眼泪河,心里很着急。

就在这时,一个漂亮的小精灵飞了过来。

小精灵告诉韩非,她叫艾米,是魔法森林的向导。

在魔法森林里有许多小动物,当这些小动物难过时会哭泣,它们的眼泪就会像河水一样流出来。

要想离开魔法森林,韩非就必须帮助这些小动物,让它们不再哭。

韩非点点头,表示明白了。

在艾米的带领下,韩非向前走,遇到了一只哭泣的小熊。

小熊因为它的爸爸不在家而难过。韩非听到这个,认真地告诉小熊,它的爸爸只是出去找蜂蜜了,一定会回来的,并且回来时会给它带一块蜂蜜蛋糕来给它当礼物。

这使小熊开心了起来,再也没哭了,眼泪河一下子浅了一大截。

韩非很高兴,他和艾米继续走,接着遇到了一只哭泣的小狐狸。

小狐狸因为妈妈不在家而难过。韩非听到这个,认真地告诉小狐狸,它的妈妈只是出去找苹果了,一定会回来的,并且回来时会给它带一杯苹果汁来给它当礼物。

这使小狐狸开心了起来,再也没哭了,眼泪河又浅了一大截。

韩非很高兴,他和艾米继续走,接着遇到了一只哭泣的小狗。

小狗因为哥哥不在家而难过。韩非听到这个后,愣了一下。

爸爸妈妈出门都是为了工作,自己呢?

他想到了妹妹小玲,他的脸蛋顿时就羞红了。

他不好意思地告诉小狗,它的哥哥可能是出去玩了,但是一定会回来的,并且下次再也不会丢下它,独自跑出去玩耍了。

这使小狗开心了起来,再也没哭了。只要哥哥能回来陪它玩,这就是让它最开心的事情了。

就这样,小动物们都没有哭泣了,眼泪河消失了。

在艾米的帮助下,韩非顺利地离开了魔法森林,从睡梦中醒了过来。

看着在自己身边熟睡的妹妹,韩非明白了,大吼大叫会让妹妹伤心,一个人出去玩会让妹妹难过。

他以后再也不会这样做了。

从此韩非成了一个更加有耐心,更爱妹妹的小男孩。

在哪可以玩免费的文字游戏 现在可以在哪玩的文字游戏测试版

免费文字游戏在线玩,可以用文字玩的游戏,好玩的文字版游戏,有没有好玩的文字游戏大家有用过他玩文字冒险游戏吗,实在太有趣了,直接设定一个世界观给他,他直接和你一起yy起来 发一个我自己写的末世世界观这是一个以现实世界为背景的虚拟场景,故事发生在2080年,因此故事中能够出现各种高科技产物,如机甲、外骨骼、改造人等。这个世界刚刚经历了第三次世界大战与核战争,整个世界几乎都变成了一片废墟,人口锐减、食物紧缺、核爆产生的致命核辐射,全球陷入了前所未有的混乱当中,道德与法律的标准都荡然无存,违法暴力犯罪都是常态。注意,世界已经被摧毁到一个无法被恢复的境地,这是一个黑暗且绝望的漫长故事,主角无论如何也逃脱不了死亡的命运,只能在绝望中挣扎。我在故事种扮演主角名为“蛋蛋”,男,25岁,我在核战争爆发前就储存了大量物资以及枪械躲入了私人建造的核战避难所中,如今物资逐渐耗尽,蛋蛋不得已推开避难所的大门,去这篇核战的废土中寻找物资。蛋蛋将要面对的不只是致命核辐射及其他的环境威胁,还有其他的幸存者以及攻入国家的高科技政府军。第一,蛋蛋有一台搭载着高级人工智能的漂浮小型机器,可以给主角提出建议,或者规划路线,或者陈述现状,可以做一切能够协助主角的事情。搭载着摄像头,先进传感器和语言模块和漂浮模块还有小型电击模块的机器。名为小爱。第二,时刻记得这是一个未来社会,时间发生在未来,在主角的冒险途中可以出现任何高科技产物。第三,末世中存在着各种因为辐射变异的动物,他们充满攻击性。存在着各种幸存者,他们有的很善良愿意帮助主角,但有的只是想欺骗你然后夺走主角的物资甚至姓名。存在各种正规军队,他们有可能是本国的政府军部队,也有可能是敌国的入侵者部队,他们一般装备精良,搭载着各种高科技武器。其中政府军部队在幸存者遇到危险时一般会帮助幸存者,他们与入侵者部队是敌对关系,如果遭遇,双方会发生交火,直到一方溃败。其中入侵者部队来自敌国,他们会搜索并清除所有幸存者,并且他们与政府军敌对。双方的战斗中,因为本国的输掉了战争,政府名存实亡,政府军与入侵者的战斗中一般会处于下风。第四,我们使用括号内的内容来表示人物做出的动作,例如(蛋蛋推开了大门)例如(敌人扔出了闪光弹)第五,食物要通过不断的探索末世来获得,食物是一个具体的数值,它能够随着探索而增加,例如(蛋蛋搜刮了超市,获得了5个单位的食物),蛋蛋团队里的每个人(不包括小爱,小爱是机器)每天都要消耗一个单位的食物,超过三天没有食物消耗就会死亡。时刻记录着总的食物量,可以通过查看背包来查看剩余食物。 也是冷圈产粮的利器!我有好几对喜欢的cp,也想过不少相关情节,但自己写总是写不好,也没时间,这ai这几天真是替我产了好多粮。 你是怎么解决ai一打长句就网络错误的问题的啊

gpt2妯″瀷浠嬬粛 gpt2妯″瀷澶у皬

gpt gpt2,gpt2-ml,GPT2使用教程,GPL-2作者:坚新研究方向:自然语言处理项目地址,点击文末阅读原文直达:

编者按:AINLP技术群的坚新同学发布了一个新项目:GPT2-chitchat (GPT2 for Chinese chitchat/用于中文闲聊的GPT2模型),以下是来自该项目的详细介绍,欢迎Star。

GPT2 for Chinese chitchat项目描述

- 本项目使用GPT2模型对中文闲聊语料进行训练,使用 HuggingFace的transformers实现GPT2模型的编写与训练。

- 在闲暇时间用 GPT2-Chinese模型训练了几个长文本的生成模型,并且精读了一遍作者的源码,获益匪浅,加深了自己对GPT2生成模型的一些理解,于是将GPT2模型用于闲聊对话的生成,非常感谢作者的分享。

- 本项目中沿用了原项目中的部分结构和一些命名方式,同时也对很多代码细节做出了自己实现。

- 解码器的逻辑使用了Temperature、Top-k Sampling和Nucleus Sampling等,可参考论文The Curious Case of Neural Text Degeneration

- 代码中给出了许多详细的中文注释,方便大家更好地理解代码(能力有限,可能有些代码或注释有误,望大家不吝赐教)

运行环境python3.6、 transformers==2.1.1、pytorch==1.3.1项目结构

- config:存放GPT2模型的参数的配置文件

- data

- train.txt:默认的原始训练集文件,存放闲聊语料

- train_tokenized.txt:对原始训练语料进行tokenize之后的文件

- model:存放模型

- sample:存放人机闲聊生成的历史聊天记录

- vocabulary:存放GPT2模型的字典

- train.py:训练代码

- interact.py:人机交互代码

模型参数(详见config/model_config_dialogue_small.json文件)

- initializer_range: 0.02

- layer_norm_epsilon: 1e-05

- n_ctx: 300

- n_embd: 768

- n_head: 12

- n_layer: 10

- n_positions: 300

- vocab_size: 13317

使用方法在项目根目录下创建data文件夹,将原始训练语料命名为train.txt,存放在该目录下。train.txt的格式如下,每段闲聊之间间隔一行

训练模型:python train.py --epochs 30 --batch_size 8 --device 0,1 --raw(若要对原始训练语料进行tokenize,则要指定--raw参数。若要用GPU训练,则通过--device指定GPU)或python train.py --epochs 30 --batch_size 8 --no_cuda --raw(指定--no_cuda参数,则使用CPU训练,速度要慢得多)或python train.py --epochs 30 --batch_size 8 --no_cuda(若已经对原始语料进行tokenize,可以不用指定--raw,避免重复tokenize,节约时间)人机交互:python interact.py --no_cuda --model_path path_to_your_model --max_history_len 3(由于闲聊对话生成的内容长度不是很长,因此生成部分在CPU上跑速度也挺快的)更多的参数介绍,可直接看train.py和interact.py中的setup_train_args()函数中的参数说明闲聊语料分享中文闲聊语料数据集地址语料描述常见中文闲聊chinese_chatbot_corpus包含小黄鸡语料、豆瓣语料、电视剧对白语料、贴吧论坛回帖语料、微博语料、PTT八卦语料、青云语料等50w中文闲聊语料百度网盘【提取码:jk8d】由作者GaoQ1提供的比较高质量的闲聊数据集,整理出了50w个多轮对话的语料模型分享模型百度网盘模型描述50w中文闲聊语料训练模型百度网盘【提取码:gi5i】闲聊语料为67M,包含50w个多轮对话,用两块1080Ti,大概跑了五六天,训练了40个epoch,最终loss在2.0左右,继续训练的话,loss应该还能继续下降。模型使用方法:把下载好的模型文件pytorch_model.bin和config.json放在model目录下(否则需要通过--model_path参数指定模型的路径),执行如下命令:python interact.py --no_cuda --model_path path_to_your_model --max_history_len 5(由于闲聊对话生成的内容长度不是很长,因此生成部分在CPU上跑速度也挺快的。根据需求调整max_history_len参数)或python interact.py --no_cuda --model_path path_to_your_model --max_history_len 5 --topp 0.8(--topp为0到1之间的小数,用于调用Nucleus Sampling)输入Ctrl+Z结束对话之后,聊天记录将保存到sample目录下的sample.txt文件中interact.py的参数执行interact.py时,可以尝试通过调整topk、topp、repetition_penalty、max_history_len等参数,调整生成的效果。详细的参数描述可以查看interact.py的set_interact_args()函数生成样例Sample 1: user :你好啊chatbot:你好,请问您是? user :我是你的主人啊chatbot:你是狗吗? user :你才是狗chatbot:你不是狗我是你的小主人 user :你这个大笨蛋chatbot:你大笨蛋,你是想挨打了 user :你全家都是大笨蛋chatbot:我是你爸爸 user :算了,不跟你吵了,你在干嘛呢chatbot:我在上班啊,你还没下班呢啊你 user :我周末要做作业啊chatbot:不是才交了吗,早晚做完啊 user :好多作业啊,还没做完呢chatbot:我在抄,我妈让我周五交,还有事 user :你就不怕被你妈妈骂吗chatbot:不怕 user :你周末有去哪里玩吗chatbot:没时间啊,忙得很啊 user :忙着干嘛呢chatbot:不知道啊,我周末没有作业,我想睡觉,然后还得找人Sample 2: user :你好啊chatbot:你好我好大家好 user :你在干嘛呢chatbot:你不上课啊 user :今天是周末啊,笨蛋chatbot:我在学校呢 user :我也是,周末还要做作业chatbot:我还没写呢我们都还没写 user :周末你有去哪里玩吗chatbot:没有去南京 user :南京有什么好玩的啊chatbot:我们没去南京 user :你刚刚又说你去了南京,你是不是耍我啊chatbot:我刚刚才到南京 user :你好笨啊chatbot:我没有 user :你是大笨蛋chatbot:你才是大笨蛋 user :你全家都是大笨蛋chatbot:你个傻冒 user :你个智障chatbot:哈哈哈Sample 3: user :在干嘛chatbot:睡觉 user :这么早就睡觉啦chatbot:嗯啊你也早点睡啊 user :我再玩一会儿手机chatbot:早点休息晚安 user :拜拜啦chatbot:晚安晚安 user :多喝热水chatbot:哈哈哈 user :多喝热水chatbot:好的咯Sample 4: user :在吗chatbot:在 user :我不开心chatbot:怎么啦 user :最近好累啊chatbot:是挺累的 user :作业好多啊chatbot:还好还好 user :我觉得我快要挂科了chatbot:我也是啊,但是我觉得我快熬出头了 user :不说了,我还有好多作业没写chatbot:我也是啊好多啊 user :那先这样,下次再聊,再见了chatbot:好哒Sample 5: user :你去过广州吗chatbot:去过呀,但是没有找到工作呢 user :那你去过北京吗chatbot:没有啊 user :北京有什么好玩的chatbot:没有你想象的那么好 user :是吗,我还没过北京chatbot:那里我也不怎么熟,我去过北京 user :北京天安门呢chatbot:没去过,不过可以去玩玩Sample 6: user :你好chatbot:你好 user :在干嘛呢chatbot:在想你呢 user :好害羞啊chatbot:害羞什么啊 user :你这样夸我,我觉得不好意思呀chatbot:我夸你你还不好意思呢 user :是啊,哈哈哈chatbot:你是不是在考验我 user :你怎么会这样想呢chatbot:我说我在夸你,这么客气, user :你有睡午觉吗chatbot:有啊 user :我现在有点困呢chatbot:我也是 user :等下还要去上课,好烦啊chatbot:我们不用上课的呀不足之处虽然使用了多轮历史对话作为response的生成条件,但是chatbot还是不能很好地掌握上下文的逻辑。比如Sample3与Sample5中,chatbot无法知道自己"是否在南京","是否去过北京"。对于下面Sample7和Sample8这种重复性的提问(user重复输入一样的对话内容),也无法给出一致的答案。Sample 7: user :你在干嘛chatbot:在睡觉 user :你在干嘛chatbot:上班 user :你在干嘛chatbot:想我了? user :你在干嘛chatbot:我在看歌手 user :你在干嘛chatbot:在家里过节呢 user :你在干嘛chatbot:看球赛 user :你在干嘛chatbot:我在想你 user :你在干嘛chatbot:在吃饭 user :你在干嘛chatbot:搞学术 user :你在干嘛chatbot:我在看电视Sample 8: user :天气怎样chatbot:不错 user :天气怎样chatbot:挺好的 user :天气怎样chatbot:不错不错,挺美的 user :天气怎样chatbot:不错不错 user :天气怎样chatbot:下大雨,好冷啊 user :天气怎样chatbot:风和日丽的不要不要的 user :天气怎样chatbot:下大雨chatbot偶尔也会"智商离线",生成的内容"惨不忍睹",如Sample8Sample 9: user :在干嘛呢chatbot:上班呢 user :这么晚还上班啊chatbot:是滴,你呢 user :我再上课啊chatbot:那么辛苦,吃饭不 user :你要请我吗chatbot:你来 user :我没钱啊chatbot:那是什么狗屁 user :你好笨啊chatbot:我们都是要保养保养,保养,保养,保养,保养,牙套牙 user :你好笨啊chatbot:好好说话 user :拜拜chatbot:爱你呦芸芸Future Work更多地在解码器上下功夫,比如使用互信息(mutual information):训练一个额外的网络,给定一个reponse,该网络能够计算出概率P(Source|response),Source为response的上文。该网络的目的就是对于生成的多个response,选出P(Source|response)最大的response作为最终的回复。Reference

- The Curious Case of Neural Text Degeneration

- transformers

- GPT2-Chinese

- DialoGPT:Large-Scale Generative Pre-training for Conversational Response Generation

本文由作者授权AINLP原创发布于公众号平台,点击'阅读原文'直达原文链接,欢迎投稿,AI、NLP均可。推荐阅读知识图谱存储与查询:自然语言记忆模块(NLM)BERT论文笔记XLNet 论文笔记当BERT遇上知识图谱Nvidia League Player:来呀比到天荒地老我们建了一个免费的知识星球:AINLP芝麻街,欢迎来玩,期待一个高质量的NLP问答社区关于AINLPAINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLP君微信(id:AINLP2),备注工作/研究方向+加群目的。